【ITBEAR】微软公司近日宣布了一项重大开源成果——bitnet.cpp,这一创新框架专为1-bit大语言模型(LLM)设计,旨在实现超高效推理。通过bitnet.cpp,用户无需依赖GPU,即可在本地设备上流畅运行规模达1000亿参数的语言模型。

bitnet.cpp不仅带来了6.17倍的速度提升,还显著降低了能耗,降幅高达82.2%。这一突破解决了传统大语言模型对GPU和电力的高需求问题,使得小型企业和个人用户也能以较低成本享受AI技术。

该框架支持1-bit LLMs的高效计算,并优化了内核以最大化CPU推理性能。目前,bitnet.cpp已支持ARM和x86 CPU,未来还计划扩展至NPU、GPU和移动设备。

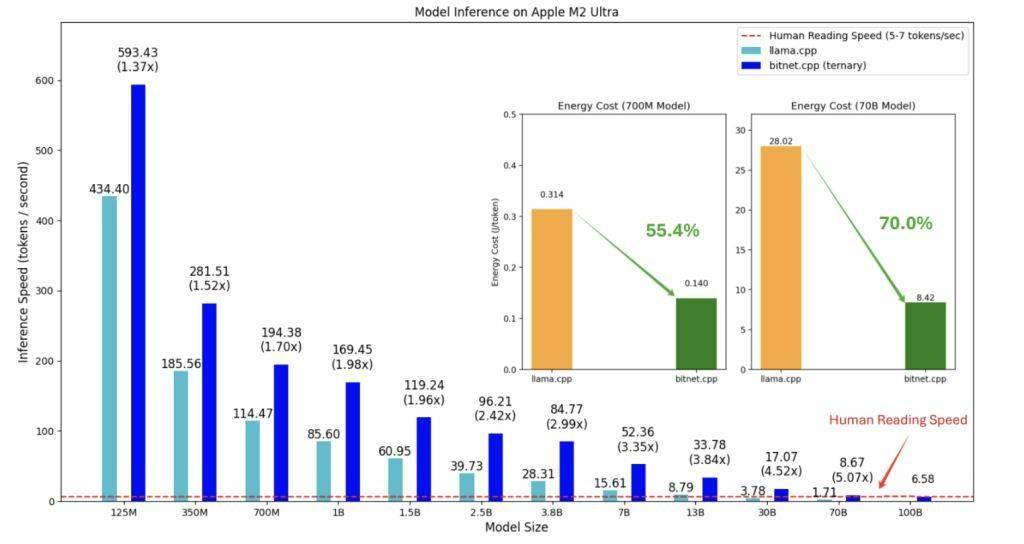

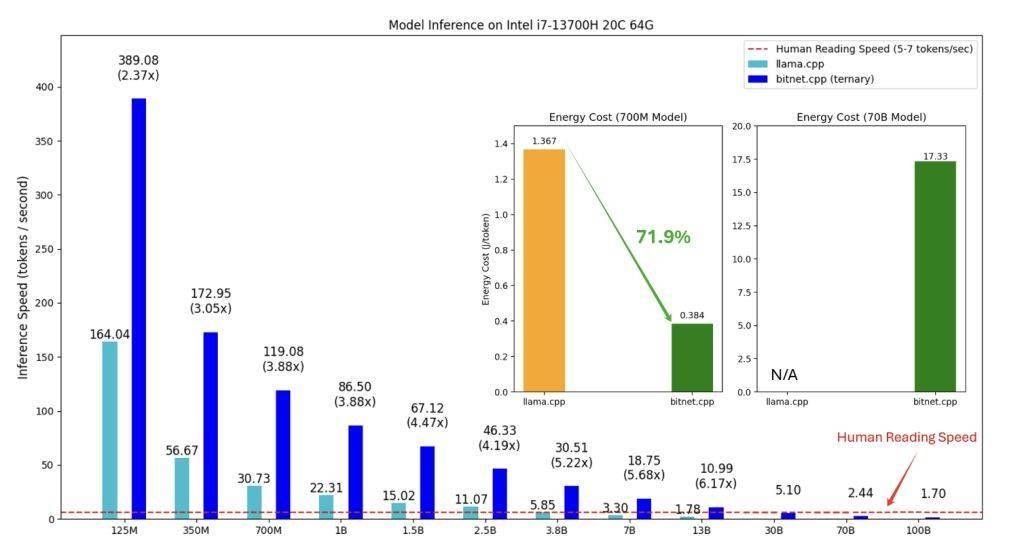

根据测试结果,bitnet.cpp在ARM CPU上的加速比为1.37x至5.07x,x86 CPU上则为2.37x至6.17x,能耗减少55.4%至82.2%。

bitnet.cpp的推出有望重塑LLMs的计算范式,减少对硬件的依赖,为本地LLMs的发展铺平道路。同时,它还能增强隐私保护,降低数据发送至外部服务器的需求。微软的“1-bit AI Infra”计划中,bitnet.cpp扮演着举足轻重的角色。